谷歌发布首款本地部署视觉-语言-动作模型,推动具身智能进化

时间:2025-06-26 06:15

小编:星品数码网

2023年6月25日,Google DeepMind正式推出其首个可完全在机器人本地部署的视觉-语言-动作模型(Visual-Language-Action, VLA)——Gemini Robotics On-Device。这一发布标志着具身智能(Embodied AI)领域的重要突破,意味着这一技术正在逐渐摆脱对云端计算资源的依赖,向本地自主操作的方向发展,这为业界扩展了新的应用场景和潜力。

具身智能在实现上曾面临两大挑战。传统模型对云计算资源的高度依赖,使得机器人在无网络或网络不稳定的环境中难以独立工作。模型庞大的体积增加了在计算资源有限的机器人上进行高效运行的困难。Gemini Robotics On-Device的推出,旨在解决这些问题。该模型能够在资源有限的设备上本地运行,展现出卓越的通用性和任务适应能力。最关键的一点是,模型无需依赖网络,这对于需要实时反应的应用场景提供了显著优势。

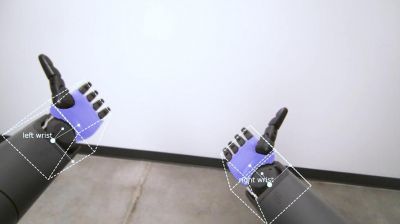

在Google DeepMind发布的演示视频中,Gemini模型展示了其在多个环节,包括感知、语义理解、空间推理和高精度执行等方面的优异性能。研究人员指出,该模型不仅具备强大的通用性和灵活性,还能够对复杂的双手任务进行即时处理与学习,一位机器人领域的工程师分析道,这意味着谷歌的新模型极大地拓宽了其应用范围和部署灵活性。

值得注意的是,Gemini Robotics On-Device虽是针对特定机器人设计训练的,但其具备良好的泛化能力,可以适应不同形态的机器人,例如双臂机器人和人形机器人,极大地提升了其应用潜力。谷歌首次开放了VLA模型的微调功能,让工程师或者机器人公司能够基于自身数据对模型进行定制训练,以此优化其在特定任务、场景和硬件上的表现,进一步提升应用效率和实用价值。同时,谷歌还推出了Gemini Robotics SDK,方便开发者进行模型评估和快速调整,令其更具灵活性。

这一进步标志着机器人技术向真实环境的有效过渡,具身智能被认为是通往人工智能通用智能(AGI)的桥梁。专家指出,基于本地VLA模型的机器人更适合在家庭、医疗、教育等敏感场景中进行操作,能够有效解决数据隐私、实时反应和安全稳定性等核心挑战。

近年来,大语言模型在“端侧部署”领域的进展已成为一种趋势。从最初依赖庞大的云端计算资源,到能够在手机、平板等边缘设备上本地运行,得益于模型的压缩优化、推理加速与硬件协同,推动了各类智能设备的普及。同样的演变正在具身智能领域逐步展开。VLA模型作为具身智能的核心结构,可以让机器人从多模态信息中理解任务并做出行动能力。此前,依赖云端资源的模型往往受限于网络带宽、功耗与实时性的瓶颈,难以在复杂环境中高效工作。谷歌此次发布的Gemini Robotics On-Device,标志着具身智能技术进入类似大语言模型的“端侧时代”。

未来的挑战依旧严峻。机器人硬件的多样性和复杂性是一个突出的问题,市场上多样化的机器人硬件意味着,即使是强大的通用模型,也是需要针对具体硬件进行细致的适配与调优。要在多样化的实际应用场景中实现有效落地,数据的收集和标注成本将是巨大的,尤其是在需要专业技术知识的工业或服务场景中。

更重要的是,机器人在复杂、动态且不可预测的现实环境中,也要求保持一定的鲁棒性。环境中的光照变化、物体遮挡、杂乱的非结构化环境,以及与人类交互过程中的细微差别,都对机器人的实时感知和决策能力提出了严峻考验。因此,确保机器人在各种实际场景中始终保持高水平的稳定性与安全性,仍然是未来具身智能发展的重要课题。

谷歌的Gemini Robotics On-Device不仅是具身智能领域的技术突破,更是一个新的起点。随着AI算力和模型架构的不断演进,具身智能有望从传统的IoT发展到以具身智能为代表的更高级阶段,未来将涌现出更多创新应用和发展机遇。