OpenAI新成员Keller Jordan:一篇博客文章助力入职与GPT-5训练

时间:2025-06-17 07:45

小编:星品数码网

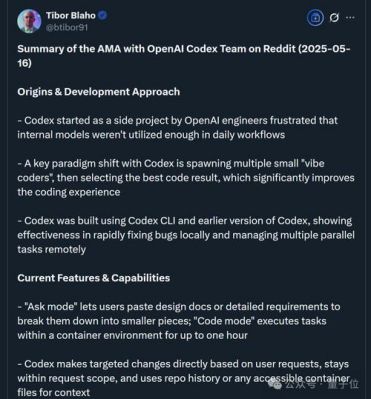

6月16日,知名AI云服务Hyperbolic的联合创始人兼CTO Yuchen Jin在社交媒体上发布了一则引人注目的消息,揭示了Keller Jordan的职业历程。Keller Jordan以一篇博客文章成功加盟了Open并有可能正在利用博客中提到的神经网络优化器Muon进行GPT-5的训练。这一消息不仅引起了科技界的广泛讨论,也重新引发了对学术研究和实际应用之间关系的思考。

Yuchen Jin在推文中指出,许多研究者常常在学术发表方面设定过高的期望,认为在顶级会议上发表论文即是成就的体现。然而真实的影响力往往并不局限于学术发表。在Twiter的推文中,Yuchen Jin提到:“Muon只作为一篇博客文章发布,但它让Keller加入了Open而他现在可能正是利用它在训练GPT-5。”这一言论揭示了博客内容的潜在巨大价值。

Keller Jordan在2024年12月发表的博客《Muon:神经网络隐藏层的优化器》成为他职业生涯的转折点。通过精炼的实证研究和设计理念,他展示了Muon如何在神经网络优化中脱颖而出。Muon被设计用于神经网络的隐藏层,显著提升了在NanoGPT和CIFAR-10任务上的训练速度,这一成就显然吸引了OpenAI的关注。

在这篇博客中,Keller Jordan定义了Muon,描述了其在训练中的应用以及对应的实证结果。他详细阐述了Muon的工作原理,包括与以往研究的关联性以及最佳实践。Muon的设计涉及到二维参数的优化,将Newton-Schulz矩阵迭代应用于SGD-momentum生成的更新中,以提高训练效率。这种方法的优越性体现在多个关键结果上:在CIFAR-10上训练时间由3.3秒降至2.6秒,同时在NanoGPT的竞赛任务中,相比标准的优化器,提升了超过1.35倍的训练速度。

Muon不仅在速度上取得了突破,同时在性能上也表现优异。Keller Jordan在其研究中指出了多个优势,包括在处理较大规模参数时保持训练速度的提升,以及在HellaSwag任务中,其模型通过Muon训练达到了与GPT-2 XL相近的性能,且所需的时间大幅缩短。

值得注意的是,Keller Jordan评估了目前神经网络优化研究领域的现状,并提出了批判性的看法。他深刻地反思了为什么许多新提出的优化器未能获得应有的认可,认为这主要源于学术界在基线设置上的问题。他提到,研究者常常忽视了对已有方法(例如AdamW)的充分调整,导致新方法的比较缺乏公正性。

为了改善这一现状,Keller Jordan建议研究者在提出新优化器时,应确保其在竞争性任务中的表现足够优秀,以便真正推动研究的前进。他认为竞争性标准可以有效验证优化器的实用性,从而提升其在市场上的接受度和应用率。

作为OpenAI的新成员,Keller Jordan的博客里面提出的Muon优化器,预计将在公司最新的大模型GPT-5的训练中扮演重要角色。这种技术的成功应用将使得OpenAI在竞争激烈的AI研究领域中进一步巩固其领先地位。同时,这一事件也在一定程度上打破了学术论文的垄断性,展现了个人研究和分享的强大潜力。

Keller Jordan的成就是对所有研究者的激励,强调了分享知识和应用实际成果的重要性。在当今的科研环境中,学术研究的价值不再仅仅体现在高影响因子的发表上,更在于能否将科技成果与行业需求有效结合。在未来,越来越多的创新和突破将依赖于研究者在实践中勇于探索,并及时分享他们的发现和想法。

而言,Keller Jordan通过一篇博客文章成功开启了自己的职业新篇章,并为OpenAI的GPT-5训练贡献了重要技术。这一事件不仅是个人职业成长的典范,也为科研界提供了反思现状和促进发展的契机。在科学研究的道路上,每一个潜在的突破,往往都蕴藏于看似普通的分享之中。随着科技的不断发展,开放与合作的精神将愈加重要,推动整个行业的进步。