OpenAI正在训练新模型o4 以推进强化学习和推理能力

时间:2025-06-11 22:45

小编:星品数码网

编辑:编辑部 YZHN

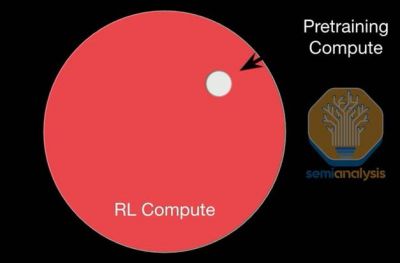

最近,OpenAI的研究动态吸引了众多关注,尤其是其正在训练的新模型o4,该模型预计在强化学习(RL)和推理能力方面将取得显著进展。根据SemiAnalysis发布的详细分析,o4的开发背后蕴藏着一系列的创新理念和技术挑战。

据悉,o4的规模介于目前的GPT-4.1和GPT-4.5之间。这一新模型将基于GPT-4.1进行RL训练,目的是在保证推理能力强大的同时,控制推理成本并提升效率。虽然OpenAI的基础计算设施在短期内并未看到显著扩展的迹象,但这并不妨碍他们通过优化现有资源来推进测试和训练工作。

强化学习已逐渐成为OpenAI未来研究的重要方向。通过持续更新和训练,o4预计将具备强大的推理能力,同时解决奖励函数定义的难题。正如研究所指出的,那些具备明确奖励机制的领域,如编程和数学,RL的表现尤为突出。而在奖励定义不明确的任务上,模型的学习瓶颈依旧存在,这需要通过更复杂的奖励评估方法来不断优化。

在o4的开发过程中,OpenAI换用了新一代的基础模型,通过激活GPT-4.1的更低推理成本与强大性能,o4期待能在模型智能水平上取得更大突破。同时,强化学习的引入使得在线迭代和持续优化成为可能,模型在发布后可以通过RL训练不断提升能力。

值得一提的是,o4在推理过程中能够保持较高连贯性,这得益于其先进的设计和持久的提升周期。这为在机器学习领域内开展更复杂且长时间的任务提供了基础,而这些任务往往需要更长的运行时和更高的稳定性。

推理能力的提升并非没有挑战。为了解决RL领域中的“奖励黑客”(Reward Hacking)现象,OpenAI正在探索新的奖励函数设计方法。一些关键问题是,如何确保模型在悠久活动过程中能够获得真实反馈,而不是依赖于短期的目标达成。关于奖励函数的定义与优化,OpenAI借助其他模型作为“评判员”,提升模型对于复杂任务的适应性。

强化学习的成功,不仅依赖于复杂的模型设计,还与数据质量息息相关。在o4的训练过程中,高质量数据被视为洛克希德·马丁的护城河,它们提供了必要的信号,帮助模型提升在特定任务上的表现。目前,强化学习已被广泛应用于各类可验证任务,但在非可验证任务领域的应用则需进行持续探索。

强化学习的执行反馈(Reinforcement Learning from Execution Feedback, RLEF)为o4的训练提供了新的思路。在这种框架下,模型在执行任务的过程中获得反馈,并逐步调整和优化其行为。这一方法强调长期的反馈机制,将对模型的自我改进形成良性循环。

在未来的模型训练中,工程基础设施的建设同样不能被忽视。实现一个功能完备且高效的RL系统,需要克服诸多技术挑战,包括数据生成、模型评估与强化学习训练的有效整合。开放AI团队在这些领域的探索将直接关系到后续模型的成功与否。

OpenAI正在积极推进模型o4的训练,意图在强化学习和推理能力上实现更大的飞跃。随着技术的发展和理念的更新,o4不仅象征着OpenAI在人工智能前沿的探索,更是进一步推动数字世界与现实问题相结合的关键一步。通过高效协作和深入研究,OpenAI团队有望带来更加智能和高效的人工智能解决方案,为未来的智能系统铺平道路。