ZeroSearch框架:激活大语言模型搜索能力,降低88%训练成本

时间:2025-06-03 20:15

小编:星品数码网

在现代人工智能领域,大语言模型(LLMs)正展现出巨大的潜力,尤其是在推理和信息检索任务中。提升这些模型的检索能力并非易事,现有的解决方案面临着诸多挑战。为了解决这些问题,研究人员提出了ZeroSearch框架,一个创新的方法,无需真实搜索引擎的参与。研究表明,该方法不仅降低了训练成本达88%,还有望提升模型的推理表现。

当我们讨论信息检索在大语言模型中的重要性时,我们必须考虑到相应的挑战。依赖真实搜索引擎可能导致文档质量的不可控性,模型在训练过程中的表现容易受到噪声干扰。同时,在Rollout阶段频繁调用搜索API会产生高昂的经济成本。因此,如何在训练中有效利用搜索能力成为了一个急需解决的问题。

為了解决这些问题,ZeroSearch框架采用了一个独特的思路:利用大语言模型自身的能力模拟搜索引擎,通过强化学习方法训练模型,而无需实际调用外部搜索接口。具体而言,ZeroSearch通过引入课程学习策略,使得训练模式循序渐进,从而有效激发大语言模型的推理能力,实验证明其在多个任务上的性能超越了传统依赖真实搜索引擎的方法。

ZeroSearch的关键创新在于将大语言模型作为模拟搜索引擎来使用,避免了与真实文档的频繁交互。在这个过程中,ZeroSearch采用了一种损失屏蔽策略,仅对策略模型自行生成的token进行损失计算,确保模型不直接记住模拟文档,进一步提升了泛化能力。

在ZeroSearch的训练过程中,模型无需经过初始的监督微调(SFT),而是直接进行强化学习训练。我们设计了结构化的交互模板,明确每一次交互中的思维步骤:该模型进行信息分析,接着提炼搜索查询,通过推理形成答案。这样的模板提升了推理路径的清晰度与可解释性,从而也优化了最终答案的奖励计算。

除了结构化模板的设计,ZeroSearch还引入了一系列的微调策略,以提升模拟搜索生成内容的质量。具体步骤包括从真实搜索中采集Query-Document对,利用评估模型对文档进行有用性判别,并基于优质的数据进行轻量级微调。此Micro-Adjust也帮助扩充模拟模型的知识边界,使得最终生成的文档在风格上更为稳健。

ZeroSearch实现了训练难度的逐步提高,通过课程学习策略逐步降低生成文档的质量,允许模型逐步适应更复杂的推理任务。在训练初期,模型的学习需求相对简单,随着训练的推进,逐渐引入更具挑战性的文档,以此优化模型的推理能力和鲁棒性。

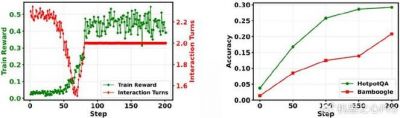

在实验中,ZeroSearch展现出了强大的性能优势。使用F1 Score作为奖励指标,让模型更加关注输出的准确性和简洁性,从而有效降低冗余答案的生成。同时,我们也发现经过微调的Simulation LLM,即便只有较小的参数量,依然可以显著提升策略模型的表现。

ZeroSearch的实验结果表明,该框架在进行大量实验时展现了优越的鲁棒性,能够在域内和域外的数据集上均有良好表现。即使低至3B参数规模的模型,也能有效激发搜索能力,而随着模型参数的增加,模型性能也得到了相应的提升。比如基于7B参数的模型性能可以与主流搜索引擎相媲美,而14B参数模型的表现甚至超越了传统搜索引擎的表现。

通过持续的训练,ZeroSearch不断提升了模型的奖励分数,尤其是在训练后期,模型的表现相较于早期有显著的改善。这表明采用课程学习策略在激发模型推理能力方面的有效性,充分验证了ZeroSearch的潜力。

ZeroSearch作为一种创新的强化学习框架,成功激活了大语言模型的搜索能力,同时显著降低了训练成本。研究表明,该框架在没有真实搜索引擎支持的情况下依然能够取得优异的性能表现,展示了其在大规模训练中的广阔应用前景。ZeroSearch不仅在基础模型与指令微调模型中表现出色,且具有较好的扩展性和适应性,此举将推动大语言模型在信息检索和其他应用场景的进一步发展。