港中文MMLab发布首个基于强化学习的推理增强文生图模型

时间:2025-05-20 03:15

小编:星品数码网

近日,香港中文大学的MMLab团队宣布推出了第一个基于强化学习的推理增强文生图(Text-to-Image Generation)模型,将“先推理、再作答”的思维模式成功引入到图像生成领域。这一突破性成果不仅提高了图片生成的质量,也为多模态互动开辟了新的可能性。

随着AI技术的不断进步,语言模型(LLMs)在多个领域展现出色表现,尤其是在解答复杂问题、编写代码等任务中。例如,OpenAI的GPT-3和DeepMind的Gato等数据驱动的模型,通过强化学习(RL)和思维链(CoT)技术,逐步分析问题并提供有效答案。这一模式也引起了研究者们的关注,试图将其在语言处理领域的成功经验转移到图像生成等其他领域。

香港中文大学MMLab团队在这一背景下,首次尝试将强化学习技术与多模态大模型结合,旨在提升图像生成任务的表现。团队通过对前期研究“Image Generation with CoT”的回顾,发现适当的推理方法能够有效促进图像生成质量提升。要充分实现这一目标,如何将语义理解与图像生成相联系,以及如何对生成结果进行质量评估,仍然是当前研究中的关键挑战。

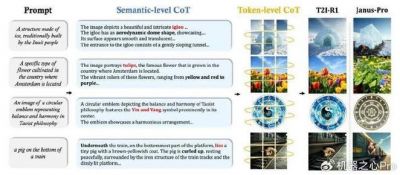

针对这一挑战,MMLab团队提出了一种双层推理解法。用户输入的一段文本信息(prompt)将经过初步推理,以明确生成图像的各种关键要素,如对象的外观、位置和环境等。模型的生成过程将以逐块的方式进行,将每个像素的生成视为一种思维链(CoT)状态,通过已有的输出逐步生成后续的图像Token。这样的双层推理解法,使得图像生成过程中能够更具连贯性,确保文本与图像之间的高度一致性。

尽管团队意识到了推理的必要性,但却发现当前主流的自回归生成模型(如Variational Autoencoder, VAE)仅仅依赖生成目标进行训练,缺乏对文本的显式理解。因此, MMLab团队在现有的统一视觉模型(Unified Visual Models, UVM)基础上,提出了新的框架,加强了对文本推理与图像生成的协同优化。

团队利用强化学习的方法,首次在一个训练迭代过程中同步优化自回归图像生成模型的两层次CoT。这一方法的核心在于,通过先生成描述图像的推理结果,再将这些结果输入生成模块,形成一个反馈循环。这样,不仅可以基于用户的提示生成多组图像,还能通过对生成内容的相对评分来优化生成过程,有效避免了传统分阶段训练的低效与高成本。

在质量评估方面,MMLab团队提出利用多个视觉专家模型进行集成,构建更为可信的奖励模型。这一策略旨在从多个维度对生成的图像进行评估,确保所生成的结果具有可靠性,并且防止模型在某一维度上出现过拟合现象。

值得一提的是,基于这一新框架,团队实现了较量性能的显著提升。在T2I-CompBench和WISE基准测试中,模型分别提升了13%和19%的性能,并在多个子任务上超越了以往最先进的FLUX.1模型。这表明,MMLab团队成功将推理模式运用到图像生成中,为未来的发展奠定了基础。

此次推出的模型不仅标志着文生图领域进入新的R1时期,更为AI生成技术的未来发展提供了广阔的可能性。研究者们对这类技术的进一步拓展到视频生成、3D内容合成等复杂生成任务充满期待。这样的技术进展,或将推动生成式AI的演变,让其向“能思考、会创作”的通用智能体迈进。

综上,香港中文大学MMLab团队的研究成果展现了强化学习在图像生成中的强大潜力,推动了多模态生成任务的发展,并为今后类似领域的研究提供了新的思路与方法。随着技术的不断进步,未来的生成式AI将更加强大,成为我们日常生活中不可或缺的一部分。