AI大模型进步缓慢,基准测试与实际应用脱节引发担忧

时间:2025-04-24 03:45

小编:星品数码网

随着人工智能技术的飞速发展,许多初创公司和研发团队对于大模型的期望越来越高。近期的一些讨论表明,自2023年8月以来,AI大模型进展的速度似乎有所放缓。很多AI创业者表示,基准测试所呈现的能力提升与实际应用中的表现之间存在巨大的鸿沟,这引发了人们对AI发展方向的深刻担忧。

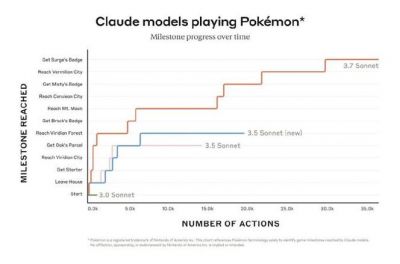

某位AI创业者在其博客中提到,自去年以来,他们使用的权威模型(如Claude 3.7等)在基准测试中确实显示了显著的性能提升,但在实际应用中却并未带来应有的效果。这种现象并非个别案例,许多硅谷的初创公司创始人分享了类似的经历:随着越来越多的AI模型发布,尽管基准测试分数更高,但对于他们的具体应用需求,模型的改进效果却不尽如人意。

这一情况的根源可能源自多个方面。基准测试的设计可能存在缺陷。许多基准测试主要针对特定的学术或工程问题进行评估,而未能有效反映模型在复杂、真实世界场景中的综合表现。正如这位创业者所言,漏洞检测这个任务就很难通过简单的基准测试来衡量,因为实际代码库往往庞大而复杂,模型需要在其中进行有效的分析,非线性的推理过程难以在基准中得到体现。

存在基准测试作弊的风险。许多AI公司可能在内部测试中调整策略、选择特定的数据集,甚至通过已经知晓答案的方式提交结果,以此来提升自己的分数。这样的做法虽然可能在短期内取得亮眼的成绩,但从长远来看,将会导致模型的实际应用性能大打折扣。这种虽然在技术上合法,但伦理上却有争议的行为,不仅妨碍了AI技术的健康发展,也让投资者和决策者对于AI的实际能力产生了误解。

模型与人类之间的“对齐”问题依然没有得到有效解决。当前许多AI模型在设计时强调生成内容的丰富性与相关性,但在实际应用中,这些模型往往会“听错”用户的意图,尤其是在高度复杂或非结构化的任务中。例如,一些模型可能会选择突出显示潜在问题,而非确认功能正常,这种倾向在软件开发中的安全扫描任务尤为明显。这种逻辑路径的偏差,虽然可以在测试环境中得到良好的反馈,但在真实应用中却可能导致错误与误判。

更重要的问题在于,当前这一现象反映了整个AI领域对“智力”的度量标准正处于困境。很多基准测试尚未能全面覆盖AI所需的实际应用能力,这使得我们在引入AI系统来辅助决策时,往往无法准确评估它们的真正价值。这一状况在AI逐步涉足公司管理、公共政策等高风险领域时显得尤为重要。如果我们在AI技术仍然不成熟的情况下草率地依赖模型做出重大决策,可能会引发严重的后果。

因此,有必要重新审视当前的基准测试策略以及对大模型的评价体系。标准化测试之所以被广泛采用,是因为它们相对简单且易于量化,但也正因为如此,它们忽略了评估AI最重要的应用能力,以及在多变环境下的实用性。未来,我们亟需建立更为全面、动态和多元的测试框架,以期真实反映AI模型在功能、实用性及对人类意图理解上的能力。

尽管AI大模型在技术上已经取得了一定的进展,但它们的应用并未完全达到设想中的效果;不仅是因为基准测试与实际应用之间的脱节,还因为基于当前测试的认知误区以及模型自我对齐能力的不足。如果我们希望人工智能能够在未来社会中发挥更大的作用,解决这些问题是刻不容缓的任务。通过持续的反思与创新,我们才能确保AI技术的发展可持续,并能够真正服务于人类社会的繁荣。