上海人工智能实验室推出SFE评测基准,推动AI在科学研究中的深度应用

时间:2025-07-11 13:45

小编:星品数码网

在当前的科技浪潮中,人工智能(AI)正逐步融入各个领域,尤其在科学研究中显现出巨大的潜力。我们所称的人工智能在科学中的应用(AI for Science,简称AI4S)正经历着深刻的变革,尤其是在大规模模型(MLLM)的推动下,科学研究的方法与流程正在被重新定义。要使这一技术成为科学研究的真正助力,仅依靠现有的评测体系与工具尚不足够,需要一个更科学、全面的评测标准来支持其深入应用。

上海人工智能实验室的AI4S团队针对当前科学评测面临的挑战,推出了全新的SFE(Scientific Framework Evaluation)评测基准,以推动人工智能在科学研究中的广泛应用。现阶段的科学评测主要集中于知识的记忆能力和简单的问答,但真实的科学研究需要从原始数据提取信息,并进行复杂的推理与分析,这就需要更高阶的认知能力。

SFE的技术报告可以通过以下链接访问:[SFE技术报告](https://arxiv.org/abs/2506.10521),而SFE数据集则可以在这里找到:[SFE数据集](https://huggingface.co/datasets/PrismaX/SFE)。SFE评测基准也已上传至司南评测集社区,欢迎大家查看:[SFE评测集社区](https://hub.opencompass.org.cn/dataset-detail/SFE)。

SFE评测基准基于“信号感知-属性理解-对比推理”的三级评估体系,意在全面考察大模型在科学研究中的能力。当前的评测涵盖天文学、生命科学、地球科学、材料科学及化学等多个领域,共包括66个多模态任务,这些任务由领域专家共同考量并设计,以确保其高价值和实际应用意义。这些任务的构建,不仅提升了评测的科学性,还有助于推动学术界和工业界对AI4S的深入理解和应用。

在SFE的评测中,研究团队与多学科领域的专家进行广泛合作,以确保构建出的数据集和任务能真实反映科学研究的需求。其过程分为三个关键阶段,包括科学挑战的确定、具体任务的设计以及基准的搭建,所有任务均基于原始科学数据并以视觉问答(VQA)形式呈现。这种设计旨在通过全面的评估模式,考察模型从数据感知到高阶推理的综合能力。

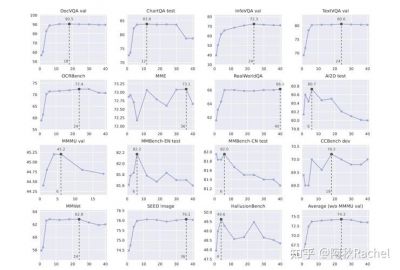

通过SFE,研究团队对16个主流的开源和闭源模型进行了系统评测,发现闭源模型(如GPT-03和Claude-3.7-Sonnet)在科学认知能力上整体优于开源模型,尤其在更复杂的推理任务中表现更为突出。这种差异的原因主要归结为模型对推理过程的控制能力,彻底突显出科学数据处理的复杂性和挑战性。

虽然主流模型在传统基准上表现出色,但在SFE的高阶科学任务上的表现却不尽如人意,显示出其在科学任务中的潜在能力短板。特别是在涉及复杂推理和深层理解的任务中,部分模型的表现仍显不足。这为未来AI在科学研究中的应用提供了改进方向和研究重点。

除了推出SFE评测基准,研究团队还建立了“棱镜”(SciPrismaX)科学评测。该汇集了模型的能力、学科多样性、评估策略和工具等多个维度,致力于构建一个严谨且契合科研实践的评估生态。通过实时监控、动态更新及与社区的合作,棱镜将持续推进AI在科学研究中的应用以及基准的迭代。

未来,随着SFE评测基准和棱镜的推广,我们期待看到更多高效且具创新性的AI工具诞生,这些工具将为科学研究带来前所未有的效率与可能性。通过科学的评测与反馈,我们可以更好地理解模型的能力边界,推动学术界、产业界和社会各界共同努力,实现科学研究的质变和飞跃。