博客引发革新:Keller Jordan凭Muon优化器成功加入OpenAI

时间:2025-06-18 16:15

小编:星品数码网

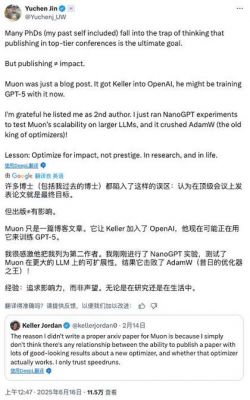

在当今的人工智能发展中,仅凭传统的学术发表似乎已不再是唯一的进阶途径。AI云服务公司Hyperbolic的首席执行官Yuchen Jin表示,许多博士研究生曾经误以为在顶级会议上发表论文就是通向成功的最终目标。现实情况却是,不同的公司和科研机构在寻求创新人才时,更加注重的是实际能力与创新思维,而不仅仅是学术论文。

一个生动的例子是Keller Jordan的成功。在2024年12月,Keller通过一篇博客而不是传统的学术论文,展示了他的创新成果——Muon优化器,从而成功加入了OpenAI的深度学习团队。这篇博客虽然未在顶级会议上发表,却在短时间内引起了业界的广泛关注,充分展示了Keller Jordan的技术水平和研究价值。

Muon优化器的创新之处

Keller Jordan在他的博客中详细介绍了Muon优化器,这是一种专门用于神经网络隐藏层的优化器,旨在大幅提升神经网络训练速度,同时保持模型的准确度。该优化器能够应用于多种类型的神经网络,包括Transformer和卷积神经网络(CNN)。通过实施Muon,Keller Jordan在训练NanoGPT和CIFAR-10数据集时,成功创造了训练速度的新纪录。

在博客中,Jordan指出了一个重要的观念转变:目前发表一篇关于新优化器的论文与其实际有效性并非总有直接关联。他相信直接呈现出有效的应用效果,快速评估优化器的实际表现,才是当前研究中更为有效的方式。他明确表达了自己的信念——创新与快速实现应当优先于繁冗的学术审核过程。

Muon优化器的技术亮点

Muon的全称是“MomentUm Orthogonalized by Newton-Schulz”,其独特之处在于通过牛顿-舒尔茨迭代(Newton-Schulz iteration)对梯度更新进行正交化,提升了标准随机梯度下降(SGD)与动量(Momentum)方法的性能。具体而言,Muon在执行标准SGD动量更新之前,对其进行正交化处理,以提高模型的收敛速度和最终性能。

博客中详细介绍了Muon在多个训练场景下的实践表现。以CIFAR-10数据集为例,Keller Jordan用A100 GPU成功将训练速度从3.3秒提高至2.6秒,表现出94%的准确性。在NanoGPT竞速任务中,他的优化器让训练速度提升至3.28的验证损失,相比之前的标准方法提高了1.35倍。Muon在处理不同规模的模型(如774M和1.5B参数的模型)时,均表现出了显著的训练速度优势。

行业的反响与后续研究

Keller Jordan的案例不仅是个人的成功,也是AI研究行业的一个指向。OpenAI等顶尖科研机构对效率和创新的高度重视,表明了研究界对于“发表为王”这一观念的反思和转变。更多的创业公司正在寻求具有实用技能与创新能力的研究者,而不仅仅关注他们的发表记录。Keller Jordan的成功为后来的科研人员提供了新的思路:在数字时代,真正的创新可以通过开放的博客和代码分享迅速传播并获得认可。

随着Muon的实现,已经有多个团队基于其进行了深入研究,有的甚至开始引入像AdamW这样标准优化器的机制,证明其在理论与实践中都展现出优越性。例如,Essential AI团队已经发布了一篇系统性的研究论文,证明Muon在大规模预训练任务中相较于AdamW具有更高的计算效率。这一研究从多个方面验证了Muon的优越性,进一步推动了这一领域的发展。

Keller Jordan的经历是促使AI行业内外思考改变的一次重要契机。在这个快速发展的领域,创新人才的获取不再仅仅依赖于传统的学术之路,个人的创造力与实践能力也显得愈加重要。Muon的成功开发和其背后的理念,展示了在AI研究中不同的路径:快速实施、开放分享,以及实用导向。这些变革不仅将改变个人的职业发展轨迹,也将在更广泛的范围内影响未来AI技术的发展方向。