新研究CLaSp:提升AI文本生成速度1.3至1.7倍,保持质量不变

时间:2025-06-08 17:45

小编:星品数码网

在的智能助理时代,我们与AI聊天机器人的对话愈发频繁,如ChatGPT、Claude或文心一言。大家是否发现,当我们提问时,AI在生成回答时常常显得“卡顿”,响应速度远不如我们所希望的那样迅速。这种延迟并非因为AI缺乏能力,而是与其内在的生成机制有关。2025年5月,由中国科学院深圳先进技术研究院、中国科学院大学、新加坡科技设计大学、新南威尔士大学及Ritzz-AI团队联合开展的新研究,提出了一项突破性的方法CLaSp(上下文层跳过的自我推测解码),旨在解决这些问题。

一、当前生成瓶颈的原因与推测解码的提出

我们需要理解大语言模型在文本生成中为何存在延迟。AI通常采用自回归的方式逐一生成文本,这需要模型在生成每个单词时,先等待前一个单词的生成完成。这就意味着在处理复杂对话时,即使强大的计算资源也可能因为开始一轮新的生成时,前面已经生成的单词继续等待而造成“闲置”状态。这一过程不仅影响了用户的互动体验,同时也没有充分利用现有计算资源。想象一下,普通的自动售票机只能逐个人处理票务,面对长队时,后面的人需要等待很久才能完成购票。

因此,推测解码技术应运而生。该技术的灵感源于计算机领域的“推测执行”概念,允许AI在生成过程中提前“预测”将可能出现的多个单词,然后一次性验证这些预测。这相当于餐厅的服务员在你点餐时,提前傻猜你可能需要的菜品,从而为你节省时间。

传统的推测解码机制通常需要两个模型:一个模型快速生成候选单词(草稿模型),而另一个则负责对这些候选单词进行验证(验证模型)。训练两个模型来确保草稿模型能精准匹配验证模型的输出,是一项非常耗时且复杂的工作。理想情况是能够建立一种更加灵活的系统,使得AI可以在生成的同时适时调整生成策略。

二、CLaSp的创新与实用性

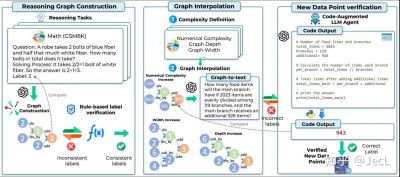

在此背景下,CLaSp提出了一种创新的解决方案,而不再需要额外的草稿模型。相较于传统的模型,CLaSp允许大语言模型自己精准掌握生成过程中的一些中间步骤,从而实现“跳过”某些计算层,进而加快生成速度。具体而言,CLaSp在生成草稿文本时,巧妙地略去模型中部分中间层的计算,在验证阶段再采用完整的模型进行质量把关。这种策略极大简化了生成过程中不必要的复杂度,达到启用更高效生成的目的。

CLaSp的关键创新之一在于能够根据实时生成的文本内容,动态调整哪些层需要被跳过。这种设计可以视为让机器在“搭建鞋柜时省略不必要的钉子”,从而节省整体构建时间。而传统的自我推测解码方法在此方面相对僵化,容易导致生成效率受限。

三、CLaSp的多阶段工作流程

CLaSp的工作流程可以划分为三个阶段:草稿生成、验证和层优化。

1. 草稿生成:模型在此阶段选择性跳过部分中间层,而快速产生一系列初步候选单词。这一过程类似于作家草拟初稿时,关注内容的快速表达,而非字句的准确性。

2. 验证:通过将草稿阶段生成的候选词汇与完整模型的输出进行核对,确定其是否符合语言综合一致性。如发现问题,模型将重新开始,直至生成合适的文本输出。

3. 层优化:通过对上一个被验证出的字词进行分析,CLaSp将优化下一次生成过程中的跳过策略,从而不断提升生成效率。

四、研究成果:速度与质量双丰收

在LLaMA3系列大语言模型上进行测试后,CLaSp展现了1.3倍至1.7倍的速度提升,且保证了生成文本质量的一致性。这一优异表现源于CLaSp有效利用模型层间的稀疏性。尤其在较大的模型中,CLaSp能够更好地发挥自身的潜力,实现更高的加速比。

研究还对CLaSp的多个参数进行了探索,适度调整跳过层数、优化间隔和草稿退出阈值后,发现其快速生成能力得以提升。而且,实验显示在模型随着规模增大时,越大模型所展现出的加速比也越优。

五、未来展望与研究扩展

CLaSp不仅为AI文本生成带来了切实的速度提升,也为未来的研究方向揭开了新的思路。这项技术为实现即插即用的推广提供了可能,为各种大语言模型推理的加速提供了一种有效的解决方案。值得注意的是,这一方法不需要额外的训练步骤,也不需要复杂的模块设计,给用户体验带来极高的实用性。

未来,研究团队将探索进一步优化这一机制,尤其在更大规模的模型中,如何更好地利用层稀疏性,以进一步降低推理延迟。将CLaSp与其它推测解码创新结合的可能性,也将为AI文本生成产生更显著的加速效果。CLaSp的成果是大语言模型领域中的一大里程碑,教会我们如何通过创新的结构来提高计算效率,同时保持生成内容质量的核心思考。