DeepSeek R1-0528发布:国产AI模型推理能力大幅提升,逐步逼近国际顶尖水平

时间:2025-06-03 02:25

小编:星品数码网

在科技飞速发展的今天,人工智能(AI)已经成为各行各业不可或缺的重要工具。而在这个领域中,国产AI模型的进展也备受瞩目。近日,DeepSeek R1-0528的发布引起了广泛关注,这一新版本不仅在推理能力上实现了显著提升,更呈现出国产模型逐步接近国际顶尖水平的良好趋势。

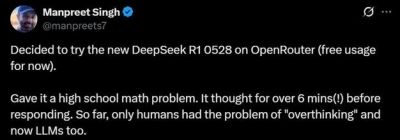

与之前的模型不同,DeepSeek R1-0528并不是简单地通过提高速度来提升性能,而是将重点放在了推理能力和思维的深度上。在复杂的逻辑任务中,R1-0528展现了其过人的推理能力,显示出国产AI模型在逻辑思维方面的不断进步。值得注意的是,DeepSeek R1-0528并未更改底层技术架构,依旧基于DeepSeek V3 Base的基础之上,但其在训练阶段投入了更为强大的计算资源,取得的成果同样令人惊喜。

在最近的AIME 2025数学推理测试中,R1-0528的准确率成功从70%提升至87.5%。这一飞跃不仅是数值上的提升,更代表了国产模型在极具挑战性的逻辑任务中获得了立足之地。这标志着DeepSeek R1-0528在原有基础上的一次质变,而这背后则是深厚的计算能力和精细的训练逻辑所提供的双重保障。

更为引人注目的是,DeepSeek R1-0528将平均解题token长度从12K提升至23K,几乎翻了一番。这一变化不仅提升了模型的“思维”深度,即在每个问题上的推理链条更加细致,且所需的逻辑步骤减少很多。这一现象的背后,既是训练数据的扩充与算法的改进,也是对推理路径的系统性优化,充分体现了DeepSeek针对推理过程在结构和内容上的多维度调整。

在AI模型开发的过程中,“幻觉”问题往往是大型语言模型面临的一个关键悖论,尤其是在中文环境下,许多当前模型仍未能彻底解决。R1-0528在幻觉率的抑制上表现相当令人满意,已达45%-50%的抑制效果,大大降低了在信息改写和摘要中的不确定性。这一进展对内容创作者愈发利用AI辅助写作是利好的消息:他们可以更大方地运用模型而不必担心产生错误信息。

更有趣的是,DeepSeek并未止于此。这一新模型中提取的思维链条也被用于另一款名为DeepSeek-R1-0528-Qwen3-8B的小型模型的训练。小模型如何能够“学会思考”一直以来是业内的一个难题。DeepSeek通过将R1的“思维轨迹”作为学习目标施加于Qwen3-8B上,成功使得其在AIME 2024中的表现接近23B规模的Qwen3-235B。这一结果表明,小模型不仅仅是缺乏思考能力,而更是由于之前缺少过深入的训练和理解。

这种思维链条的有效迁移预示着未来在训练小型模型中,思维过程的知识转移将成为一种新标配。这一方法不仅在资源使用上更为高效,同时也提高了模型的智能密度,从而极大地提升了其使用价值。

从更广泛的视角来看,DeepSeek R1-0528不仅仅是技术上的一届升级,它更是国产模型迈向“解释型AI”的关键一步。R1-0528并不再是一个封闭的黑箱工具,而是努力让用户能够清晰地看到其推理过程。新版API的更新支持Function Calling和Json Output的功能,max_tokens的定义也从“输出长度限制”进化为“全流程长度上限”。这些看似微小的改动,实际上展现出DeepSeek在模型服务方面正逐步趋向于“过程透明化”,而非单纯的“结果导向”。

更值得一提的是,DeepSeek R1-0528的上下文长度已经扩展到128K,这为处理复杂长文本和多轮上下文的任务提供了更强的支持,显示出DeepSeek在“模型体验”方面逐步和国际技术巨头们接轨。

尽管在顶级模型的整体表现上,DeepSeek仍有待与o3、Claude 4等国际同行持平,但在某些具体指标上,尤其在数学和工具调用的能力方面,已有所追赶。这一版的小更新尽管看似不起眼,却为国产模型的推理能力开辟了新天地。

DeepSeek R1-0528的发布不仅标志着国产AI模型的技术进步,更在不断缩短与国际先进水平的距离。这一系列“内功优化式”的小步跨越会成为国产模型未来更高层次发展的基石,推动整个行业不断向前发展。虽然当前的成果可能还不能立即显现,但未来的潜力则不可限量。