上海交通大学EPIC Lab推出首个免训练的高效推理机制 加速扩散式大语言模型推理

时间:2025-05-30 04:55

小编:星品数码网

摘要:

上海交通大学EPIC Lab团队近日推出了一种革命性的新方法——dLLM-Cache,这是第一个无需训练的推理缓存机制,旨在显著提升扩散式大语言模型(dLLMs)的推理效率。这一创新的推理机制为使用该类模型的研究人员和工程师们提供了一种更便捷的、高效的解决方案,推动了语言生成领域的进一步发展。

引言:

随着大语言模型(LLMs)在自然语言处理任务中的广泛应用,基于扩散的语言模型(dLLMs)因其独特的建模能力和优越的性能逐步受到关注。特别是采用迭代去噪的生成过程,dLLMs能够支持双向建模和全局依赖,已经在多项任务中超越了传统的自回归模型(ARMs)。为了确保生成质量,dLLMs在推理时需要经历大量的去噪步骤,每一步的特征计算都相当耗时,造成了推理效率的大幅下降。因此,提高dLLMs的推理效率成为一项亟待解决的技术挑战。

研究动机:

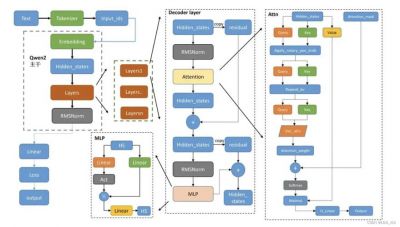

dLLMs的推理过程常常需要执行数百步的去噪迭代,每个步骤都需要重新计算所有层的特征,这不仅消耗了大量的计算资源,也限制了模型的实际应用。为了应对这一挑战,EPIC Lab的研究团队提出了dLLM-Cache,这一方法的核心在于重新利用相邻时间步上变化较小的特征,仅对变化显著的特征进行更新,从而有效减少计算量,同时保留生成质量。

dLLM-Cache的创新机制:

dLLM-Cache有几个引人注目的优点:

1. 训练无关性:该机制的主要优势在于其无须修改模型参数或进行重新训练,完全在推理过程中运作。在保持生成质量的前提下,dLLM-Cache实现了最高9.1倍的推理速度提升。

2. 广泛适用性:dLLM-Cache不仅适用于LLaDA、Dream等多模态模型,还可以扩展到其他基于dLLMs的架构。

研究团队对dLLM推理过程中的特征变化做了深入分析,发现prompt tokens的特征在整个去噪过程中基本稳定,而response tokens中的变化则相对较小。基于此发现,研究团队提出了一种名为V-verify的机制,用于有效判断哪些特征需要更新。

在具体实现上,dLLM-Cache采用“长间隔”与“自适应”的组合策略。对于prompt部分,每经过Kp步更新一次全部特征;对于response部分,则采用更频繁的更新策略,确保变化最大的tokens得到及时更新,而保持稳定的tokens不再重复计算。

实验结果:

团队在LLaDA B和Dream 7B等开源dLLM模型上进行了严格的实验验证,评估的维度不仅包括加速效果,还重视生成质量的保持。实验结果表明,dLLM-Cache在多项基准任务中的推理速度显著提升,同时生成质量未出现下降,甚至在某些情况下有所提升,显示出其良好的适应性。

特别是在与主流基于自回归模型的LLM(如LLaMA3)比较中,dLLM-Cache使得LLaDA的推理速度首次超过LLaMA3,证明了该方法在加速方面的卓越表现。

上海交通大学EPIC Lab近日提出的dLLM-Cache提供了一种高效的解决方案,满足了扩散式大语言模型在实际应用中的需求,具有广泛的应用潜力。通过减少计算负担,同时保持生成质量,dLLM-Cache将大幅提升dLLMs在各类自然语言处理任务中的应用价值,推动该领域的发展。

未来,EPIC Lab团队将继续致力于深入研究dLLMs的推理机制,探索更多可能的优化方案,以期实现更高效、更智能的推理与生成系统。研究成果已在相关学术论文中发布,并提供了开源代码供科研人员和开发者使用,希冀能在业界引发更多交流与合作。

论文链接和开源代码:

论文链接: [dLLM-Cache论文](https://github/maomaocun/dLLM-cache/blob/main/asset/paper.pdf)

代码已开源: [dLLM-Cache代码](https://github/maomaocun/dLLM-Cache)

通过这一具有里程碑意义的研究, 上海交通大学EPIC Lab为推动人工智能的边界迈出了坚实的一步。