香港大学与华为实验室合作推出AI图像生成模型LiT,实现离线1K分辨率快速生成

时间:2025-02-01 18:50

小编:星品数码网

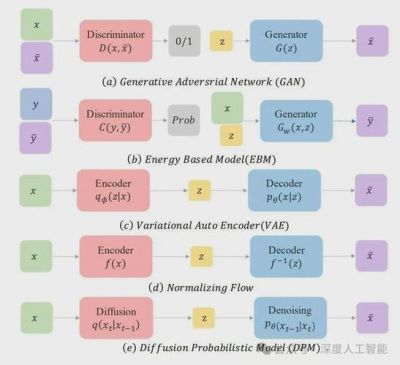

随着人工智能技术的不断进步,图像生成模型的科研和应用正在呈现出飞速发展的趋势。近期,香港大学与华为诺亚方舟实验室共同研发的AI图像生成模型LiT,在图像生成的效率和质量上取得了显著突破。该模型不仅能在离线状态下高效生成1K分辨率的逼真图像,还具备在终端设备上快速部署的能力。

LiT模型基于对扩散模型中简化线性注意力机制的深入探索,旨在解决传统扩散模型在计算复杂度上面临的挑战。经典的自注意力机制在处理高分辨率图像时,计算复杂度高,存储需求大,不适合在资源有限的端侧设备上实施。为了解决这一问题,LiT引入了线性注意力机制,其主要特点是在保持模型性能的同时,大幅降低计算复杂度,特别是在高分辨率图像生成任务中表现出尤为显著的优势。

在具体实现中,LiT-0.6B版本可以在Windows的笔记本电脑上进行离线部署,用户只需遵循模型的指令,即可在短时间内生成1K分辨率的高质量图像。这一成就为人工智能内容创作的发展打开了新的大门,也为边缘计算设备上的应用场景提供了可能。

在近期的研究中,这一团队不止一次验证了线性注意力算法在生成高质量图像方面的有效性。他们将线性注意力的结构简化,使得其在处理高分辨率图像时,不仅提升了计算速度,还降低了内存消耗。例如,使用线性注意力对2048px分辨率的图片进行生成时,LiT的计算速度比传统自注意力机制快约9倍,而所需的GPU内存也从14GB缩减至4GB。这一显著的性能提升,使得LiT成为高效生成图像的理想选择。

值得一提的是,LiT在设计上遵循了一些有效的指导原则,比如通过从预训练好的扩散模型中使用权重继承,提升模型的训练效果和性能。这一策略不仅降低了模型训练所需的计算时间,还确保了模型在图像生成质量上的一致性。LiT的团队还示范了如何通过知识蒸馏策略加速模型训练,提高了模型在生成任务的效果,进而助力AI在实际应用中的快速落地。

在多项实验中,LiT的性能同样令人印象深刻。与其他主流的扩散模型相比,LiT在较少的训练迭代次数下,依然取得了与大型模型相媲美的FID(Fréchet Inception Distance)分数。例如,在ImageNet数据集上,LiT仅使用DiT的20%和23%的训练迭代次数,就达到了相当的生成质量。这表明,LiT不仅在计算效率上占据优势,且在生成质量上亦毫不逊色。

用户也可以通过在线演示,直观感受到LiT生成图像的能力。一则视频展示了LiT在离线情况下高效生成1K分辨率图像的整个过程。用户只需给出简单指令,便证LiT强大的即时生成能力。这种技术的实际应用场景非常广泛,例如图像编辑、艺术创作、虚拟现实等领域,都有望借助LiT的强大功能实现更多创新。

随着LiT的推出,我们可以期待AI技术在图像生成领域的进一步深化。未来,随着边缘计算和智能设备的不断普及,LiT这样的高效模型将为人类生活带来深远的影响。无论是在艺术创作还是商业应用中,LiT都展现出了巨大的潜力,成为值得关注的前沿项目。

香港大学与华为实验室的合作所推出的LiT模型,不仅在技术上实现了重要突破,也为生成图像的应用开辟了新的可能。随着后续研究的深入,我们有理由相信,LiT将在人工智能的普及与发展中发挥更加重要的作用。