研究揭示大部分语言模型蒸馏程度过高影响性能

时间:2025-01-22 01:00

小编:星品数码网

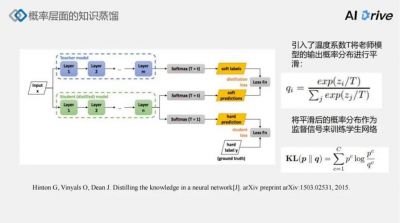

近年来,语言模型(Language Models, LMs)的发展引起了广泛关注,尤其是大型语言模型(Large Language Models, LLMs)的出现,它们展现出了卓越的自然语言处理能力。伴随技术进步而来的是关于模型蒸馏(distillation)的探讨,这是将知识从大型语言模型传递到较小模型的一种技术,旨在提高效率并降低计算成本。最近的研究显示,过度的模型蒸馏可能会造成相反的效果,从而削弱模型的性能。

最近,由中国科学院和北京大学等多家研究机构的研究团队推出了一种新的评估框架,从两个关键要素出发,以量化和分析语言模型蒸馏的影响。他们的研究结果表明,除了豆包(Doubao)、Claude和Gemini以外,绝大多数开源和闭源的语言模型显示出过高的蒸馏程度。这一发现引发了对当前技术发展的深入思考,特别是在多样性和稳健性方面。

模型蒸馏的目的是将大型模型中蕴含的知识提取并应用于较小的模型,以提高其效率和性能。过度蒸馏则可能导致模型之间的同质化,进而降低其在处理复杂任务或新任务时的表现。这一过程缺乏透明性,使得研究人员很难量化学生模型与教师模型之间的真实差异。为了解决这一问题,研究团队提出了两个新的量化指标:响应相似性评估(Response Similarity Evaluation, RSE)和身份一致性检测(Identity Consistency Evaluation, ICE)。

RSE通过对学生模型的输出与参考模型的输出进行比较,以评估响应之间的相似性,从而量化蒸馏程度。研究者自定义了一组提示集,以评估不同模型在多种推理任务中表现的相似程度。ICE则关注于通过迭代生成提示,探测模型对身份信息的自我认知。一旦模型展现出不一致或矛盾的回答,即可推测其受到了蒸馏影响。

观察结果显示,基础大语言模型普遍表现出比经过对齐(alignment)后的大语言模型更高的蒸馏水平,尤其是在闭源模型中更为显著。以GPT系列模型为例,其表现出明显的相似性,而如Llama3.1-70B-Instruct和Doubao-Pro-32k等模型的表现则相对较低。这一现象不仅影响了模型的输出质量,还使得模型的应变能力受到了显著限制。

针对这一问题,研究者强调了在未来的大语言模型发展中,应进行更为独立和透明的开发。同时,他们呼吁相关团队提供清晰的技术报告,以帮助提升模型的稳健性和安全性。这一倡导对于确保模型能够有效应对多样化的应用场景具有重要意义。

这一研究的意义还在于它促使学术界和工业界对大语言模型的蒸馏过程进行更加细致的反思。虽然模型蒸馏在提升小型模型性能方面是一项重大技术,但其潜在风险亦不能被忽视。今后的研究需要聚焦于如何在保留模型性能的同时,避免过度蒸馏带来的负面影响。

加强对模型蒸馏过程的科学评估和有效监管将是未来研究的重要方向。通过不断优化和调整模型蒸馏的策略,确保模型在安全性和多样性方面保持平衡,从而推动自然语言处理技术的持续进步。研究团队的发现为这一目标的实现提供了理论基础和方法指导,也开启了对语言模型蒸馏重要性的新视角。这一新方法不仅能帮助研究者更好地理解当前技术的局限,也为今后的技术创新提供了启示。

过度的语言模型蒸馏不仅会影响模型的性能,还会导致模型之间的同质化,从而降低其多样性和适用性。这一研究提醒我们,在追求技术进步的同时,必须保留足够的多样性和创新能力,以适应不断变化的语言任务。因此,研究者的工作为促进语言模型的健康发展打下了坚实的基础,同时也为未来研究指明了方向。