微软研究院与清华北大合作推出奖励推理模型,大幅提升复杂查询准确率

时间:2025-07-29 11:40

小编:星品数码网

近日,微软研究院与中国顶尖学府清华大学、北京大学联合组成的研究团队,成功推出了一种名为奖励推理模型(Reward Reasoning Models, RRM)的新型智能算法。这一模型的诞生,标志着在复杂查询处理和自然语言理解方面又迈出了重要一步,特别是在提高准确率和计算资源利用效率方面具有显著的应用前景。

强化学习(Reinforcement Learning, RL)作为深度学习领域的一种关键技术,近年来已被广泛应用于大语言模型(Large Language Models, LLM)后训练的主要方法之一。通过人类反馈(Reinforcement Learning from Human Feedback, RLHF)或可验证奖励(Reinforcement Learning with Verified Rewards, RLVR),这些模型能够获得更精准的引导信号,使其在处理复杂任务时表现更加优异。目前的RLVR方法存在一些局限性,尤其是在需要处理数学推理和复杂查询时,往往受到验证答案的限制,使得模型在大规模通用领域训练中难以产生优异表现。

据了解,当前市场上的奖励模型大致分为标量型和生成型两种类型,然而这两种类型控制计算资源的方式仍显单一,无法为复杂查询分配适当的计算管理。现有方式对所有输入均以统一方式分配资源,导致在应对复杂查询时缺乏深入的分析能力和效果评估,因此最终的性能表现往往不尽如人意。

为了解决这一系列问题,微软研究院与清华、北大团队共同推出的奖励推理模型RRMs采用了一个全新的思维。RRM模型在给出最终奖励之前,明确进行了推理流程,以此动态适配和分配计算资源。这种创新的思路在于其运用了“思维链”(Chain-of-Thought)推理机制,该机制在处理奖励不明显的复杂查询时,能够合理投入更多的计算资源。

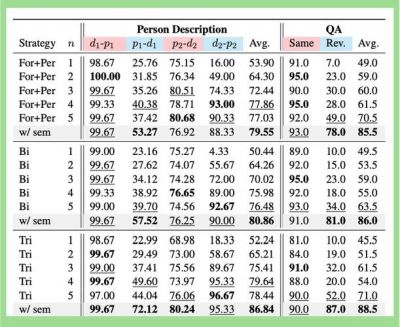

具体RRMs基于Qwen2模型,设计采用了Transformer-decoder架构,将奖励建模转变为文本补全任务。通过生成合理的推理过程,模型随后给出最终的判断和结果。研究团队在这一过程中还极为重视模型的评估表现,使用了RewardBench库进行系统分析,涵盖指令遵循性、帮助性、准确性、无害性和细节水平等多个评估指标。

更进一步,RRMs还支持多响应评估机制,借助ELO评分系统与淘汰赛机制,结合多数投票法显著提升了计算资源的利用率。通过多重评估机制的交叉考量,RRM在处理复杂信息时能够更为高效地达到准确率的提升。测试结果显示,RRMs在RewardBench和PandaLM Test基准测试中的表现均惊艳。在推理类别上,RRM-32B更是达到了98.6%的准确率,而与相同期望值的DirectJudge模型相比,RRMs显现出了明显的性能优势。

研究显示在奖励引导的最佳N推理(Best-of-N Inference)和后训练反馈中,RRMs的表现亦超越了所有的基线模型,更加优化了多数投票机制的效率。从模型规模的扩展来看,RRMs从7B、14B到32B的提升,更长的推理时间与准确率必然呈正相关,体现出该模型在推理时间与精度上的有效性。在并行与顺序扩展的过程中,RRM能够高效地利用计算资源,成为传统标量奖励模型的强大替代品。

这一成果不仅在技术层面上具备了革命性意义,同时也为实际应用提供了新的可能性。例如,在教育、金融、科技等众多领域,复杂的数据查询与决策支持将借助RRMs提供更多可行方案与策略,进一步推动行业数字化转型的进程。领域的一项重要里程碑,相信这一模型的不断完善和发展将引导未来智能系统向更高更深的智能层次迈进。

RRMs的推出为复杂查询的准确性和资源利用效率提供了有效解决方案,是微软与国内高校合作的又一成功案例,展现了人工智能领域在创新与实践中所取得的丰硕成果。期待在未来的研究与应用中,RRMs能够继续发挥其潜力,为更多行业带来新的变革与提升。