苹果与复旦大学合作推出StreamBridge框架,提升实时视频理解能力

时间:2025-06-06 06:00

小编:星品数码网

在快速发展的科技背景下,实时视频理解已成为众多领域的重要研究方向。尤其是在自动驾驶、机器人技术及智能监控等应用场景中,如何快速且准确地对视频流进行理解和响应,成为各大科技公司与研究机构面临的核心挑战。针对这一需求,苹果公司近日联合复旦大学,共同推出了全新的StreamBridge框架,旨在提升实时视频理解能力。

视频内容获取的多样化和实时性要求,传统的视频大语言模型很难满足这些场景中的复杂需求。大多数现有模型主要擅长处理静态视频数据,缺乏对动态视频流的理解能力。在动态场景中,模型不仅需要理解最新的视频片段,同时还需对历史视觉和对话上下文进行保留和处理,进行多轮实时理解。传统模型的被动响应机制使其无法主动监测视频流并及时作出反馈,这在某些特定应用中显得非常不足。

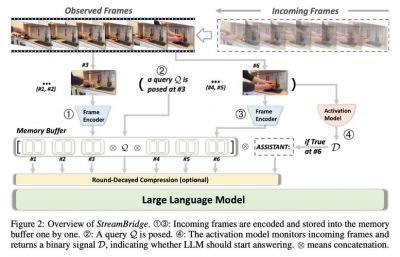

为了解决这些问题,苹果与复旦大学的研究团队深入探讨并开发了StreamBridge框架。该框架的核心优势在于其内存缓冲区和轮次衰减压缩策略的结合,能够有效支持长上下文的交互,保证模型在理解连续视频时不丢失重要信息。通过这种机制,StreamBridge不仅能处理最近的视频片段,还能维持先前状态的信息上下文,确保理解的连贯性和准确性。

StreamBridge引入了一种轻量化的独立激活模型。这个模型的设计旨在无缝集成现有的视频大语言模型,从而实现主动响应功能。在这种模式下,模型的工作方式更接近于人类的感知与反应,能够在没有明确指令的情况下,主动监控视频流并识别出需要反馈的情况。这种能力的提升,将大大增强在关键时刻的处理能力,如在自动驾驶中及时对障碍物做出反应,或者在安防监控中迅速反馈可疑活动。

为了验证StreamBridge框架的有效性,研发团队还推出了名为Stream-IT的数据集,包含约60万个样本,这些样本融合了视频与文本序列,支持多种指令格式。这一数据集的推出,旨在通过丰富的训练数据来进一步提升流式视频理解的能力,使得训练出的模型在实际应用中能够表现得更加出色。

在对主流离线模型如LLaVA-OV-7B、Qwen2-VL-7B和Oryx-1.5-7B进行测试时,结果显示StreamBridge框架在性能上均有显著提升。特别是在OVO-Bench和Streaming-Bench测试中,Qwen2-VL的平均分分别提升至71.30和77.04,超越了市场上现有的GPT-4o和Gemini 1.5 Pro等知名模型。这一成绩不仅证明了StreamBridge框架的优秀性能,也为未来在流式视频理解领域的发展奠定了基础。

虽然LLaVA-OV 在性能评测中略有下降,但Oryx-1.5却取得了显著的进步,进一步说明StreamBridge的适用性和灵活性。微调Stream-IT数据集后,这些模型的表现均有不同程度的提升,这充分显示了StreamBridge框架在流式视频理解任务中的强大潜力。

苹果与复旦大学的这次合作标志着在实时视频理解技术领域的一次重要突破。StreamBridge框架的推出可能会引领未来相关技术的进一步发展,推动自动驾驶、智能监控、无人机等多个应用领域的创新和进步。随着这一技术的不断完善及应用,未来我们有望见证实时视频理解的能力如何改变和提升我们对复杂场景的感知与反应能力,真正实现智能化的未来生活。

在许多领域,实时反馈和理解是实现自动化和智能化的关键,而StreamBridge为这一目标的实现提供了强有力的技术支持。随着团队改进模型的努力,预计将在更多场景中应用这一创新框架,带来前所未有的便利与安全保障。